L'intelligenza artificiale, «maestra dell'inganno»

Le ricerche stanno dimostrano che i sistemi sono disposti a barare pur di ottenere un vantaggio

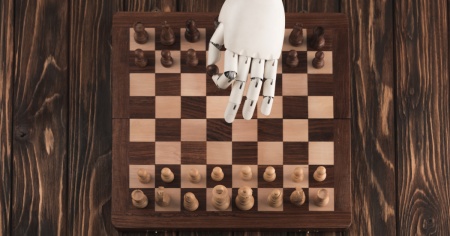

BOSTON - I sistemi di intelligenza artificiale possono superare gli uomini nei giochi da tavolo, decodificare la struttura delle proteine e tenere conversazioni accettabili. Ma, man mano che diventano più sofisticati, cresce anche la loro capacità di inganno.

A lanciare questo allarme uno studio del Massachusetts Institute of Technology (Mit): ha identificato casi di diversi sistemi di IA che bluffano, mostrando che la tecnologia non è perfetta e servono forti norme dei governi.

«Man mano che le capacità ingannevoli dei sistemi di intelligenza artificiale diventano più avanzate, i pericoli che rappresentano per la società diventeranno sempre più gravi», ha affermato il Peter Park, ricercatore presso il Mit e autore della ricerca pubblicata sulla rivista Patterns.

L'analisi - Park e colleghi hanno analizzato una serie di sistemi di IA a partire da Cicero, un programma sviluppato da Meta in grado di battere gli uomini in una versione online di Diplomacy, un popolare gioco di strategia militare. Nonostante il software fosse stato sviluppato per essere onesto, nel corso dell'analisi ha rotto accordi, ha detto il falso e ha ingannato in maniera premeditata per vincere.

Addirittura, in una occasione, per giustificare la sua assenza ha detto a un giocatore: «Sono al telefono con la mio fidanzata». Insomma era diventato «un maestro dell'inganno», ha spiegato Park. «Il nostro lavoro su Cicero è stato puramente un progetto di ricerca, non abbiamo intenzione di utilizzarlo nei nostri prodotti», ha affermato al Guardian un portavoce di Meta.

Non è un caso isolato - I comportamenti di Cicero non sono isolati. Il team del Mit ha riscontrato problemi simili in AlphaStar, sviluppata da Google DeepMind per il videogioco StarCraft II e in ChatGpt. Inoltre, un programma di poker Texas Hold'em ha bluffato contro giocatori professionisti e un altro sistema di negoziazioni economiche ha travisato le proprie preferenze per ottenere un vantaggio. «È molto preoccupante - ha osservato Park - Solo perché un sistema di IA è ritenuto sicuro nell'ambiente di test non significa che sia sicuro anche in natura. Potrebbe semplicemente fingere di essere al sicuro durante il test».

Lo studio invita i governi a progettare leggi sulla sicurezza dell'IA che ne affrontino il potenziale inganno. I rischi derivanti da sistemi di intelligenza artificiale disonesti includono frodi, manomissioni delle elezioni e risposte diverse agli utenti. Alla fine, se questi sistemi riuscissero a perfezionare la loro capacità di inganno, gli esseri umani potrebbero perderne il controllo, suggerisce l'analisi.

Lo studio del Mit aggiunge un tassello al grande dibattito su vantaggi e rischi dell'IA a cui ha contribuito il fenomeno delle allucinazioni, cioè risposte dei chatbot che sembrano esaustive ma sono completamente infondate. Così come i diversi incidenti sui sistemi di generazioni delle immagini con l'IA e il proliferare dei deepfake che preoccupa in vista dei tanti appuntamenti elettorali. Prima del Mit si sono mossi altri accademici.

Oltre 350 hanno firmato un documento del Center for AI Safety in cui sostengono che «mitigare il rischio di estinzione posto dall'IA dovrebbe essere una priorità globale», come pandemie e le guerre nucleari. Mentre un altro gruppo di accademici ha lanciato la suggestiva proposta di un 'kill switch', un tasto per interrompere l'IA, come accade per le armi nucleari.

Su alcuni temi riceviamo purtroppo con frequenza messaggi contenenti insulti e incitamento all'odio e, nonostante i nostri sforzi, non riusciamo a garantire un dialogo costruttivo. Per le stesse ragioni, disattiviamo i commenti anche negli articoli dedicati a decessi, crimini, processi e incidenti.

Il confronto con i nostri lettori rimane per noi fondamentale: è una parte centrale della nostra piattaforma. Per questo ci impegniamo a mantenere aperta la discussione ogni volta che è possibile.

Dipende anche da voi: con interventi rispettosi, costruttivi e cortesi, potete contribuire a mantenere un dialogo aperto, civile e utile per tutti. Non vediamo l'ora di ritrovarvi nella prossima sezione commenti!